Especialistas en estadística, cómputo y epidemiología de diversas dependencias de la UNAM se unieron para colaborar en el desarrollo de modelos epidemiológicos para la comprensión de la epidemia de Covid-19 en México, así como su pronóstico y la evaluación de planes de contingencia.

El grupo de trabajo denominado “Modelado matemático para la toma de decisiones sobre la pandemia causada por el COVID-19” inició sus investigaciones a finales de marzo y en mayo enviaron a publicación sus resultados, aún en arbitraje para Scientific Reports.

A este equipo pertenece la investigadora y profesora de la Facultad de Ciencias (FC), Natalia Bárbara Mantilla Beiners, quien tiene una amplia trayectoria en el área de análisis y caracterización de modelos epidemiológicos.

“Lo que estuvimos haciendo es utilizar un enfoque bayesiano para estimar los parámetros de un modelo que nos permitiera incorporar tanto a personas que estaban simplemente infectadas y eran contagiosas, como a quienes habían evolucionado de manera no tan favorable, requiriendo hospitalización, o incluso terapia intensiva”.

Aplicaron este enfoque a la evolución potencial de Covid-19 en la Ciudad de México —cuyo descenso estiman para septiembre, bajo el supuesto de que continúe la Jornada Nacional de Sana Distancia— y evaluaron si los planes de contingencia están teniendo éxito o no.

En entrevista, la investigadora refiere los principales objetivos, metodología y resultados de este trabajo, que arrojó datos importantes —con un acercamiento conservador—, que puede utilizarse para la toma de decisiones ante esta pandemia, además se reportó en un afiche a la Rectoría de la UNAM.

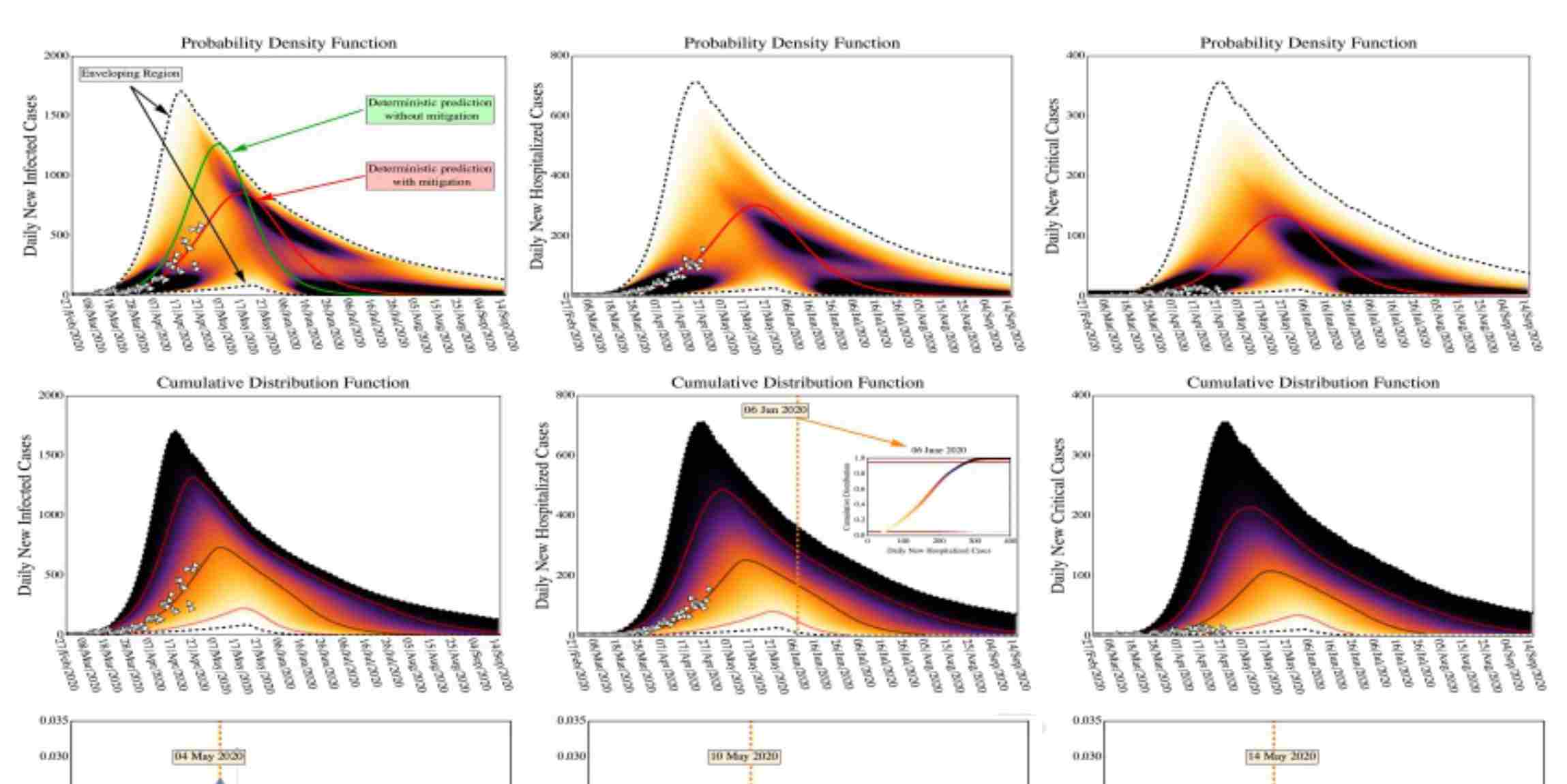

Una forma de enfrentar esta incertidumbre es utilizar estadística bayesiana para usar el rango completo de estimaciones de parámetros y proyectar en cada caso la evolución que se prevé.

“La intención era utilizar especialmente esas estimaciones que nosotros pudiéramos hacer, del número de personas que necesitaban cuidados intensivos, con el fin de ver cuál era el nivel de reducción de la tasa de contagio que era necesario para que no se superara la capacidad hospitalaria”.

De esta manera trabajaron con datos agregados de todo el país y con datos de la CDMX pero, debido a que la pandemia se manifiesta de manera diferente en distintas poblaciones de México, y a la mayor certidumbre que se tiene de la evolución epidemiológica en grandes aglomeraciones decidieron enfocarse solo en la capital.

Para Natalia Mantilla, las ciudades grandes favorecen la posibilidad de encontrar parámetros con mayor precisión, y la “gracia” de utilizar el enfoque bayesiano es que permite abordar un problema que se presenta siempre con este tipo de modelo, el cual se clasifica como sloppy.

“No sé si se pueda interpretar o traducir como frágil, porque desde el punto de vista matemático es un poco lo que son. Pero el problema que presenta un modelo de ese tipo es que cuando uno utiliza los datos para intentar estimar los parámetros, obtiene rangos de valores muy amplios para los parámetros, y todos ellos ajustan bien los pocos datos que tienes”.

El problema —explica— surge porque aunque se obtengan rangos muy amplios de valores, a la hora de utilizarlos para parametrizar el modelo, corriéndolo más en el largo plazo, la predicción es muy diferente. Al no poderse determinar de manera única cuáles son los parámetros adecuados, es preferible considerar el rango completo y tener presente que pueden obtenerse predicciones muy diferentes.

“Dado que el virus es nuevo para la población humana y que puede haber particularidades de la población mexicana relevantes para su dinámica aquí, decidimos que no íbamos a tomar estimaciones de parámetros dadas en otras publicaciones. Preferimos, en cambio, considerar todo el abanico de posibilidades que nos da y considerar el peor escenario que nos daba ese abanico de posibilidades para no errar al predecir cuáles eran las demandas que había sobre el sistema sanitario”.

De acuerdo con la especialista, uno de los problemas que se enfrentan al intentar modelar una infección que es completamente nueva, es que no hay de dónde tomar los parámetros. Si bien algunos pueden tomarse de la literatura, esto no siempre es conveniente.

“Hay algunos parámetros, en específico estoy pensando en la tasa de letalidad que tiene esta infección, o mejor decir, qué fracción de los casos reales que hay en la población representan las muertes, que pueden ser particulares para la población mexicana; puede ser diferente de la que se observa en China o en Alemania, no sólo por una cuestión genética, sino por diferencias en el sistema de salud, la alimentación, y a la comorbilidad con enfermedades crónicas que se sabe agravan la respuesta”.

Por ello, hay parámetros que es necesario estimar para la población mexicana, en lugar de referir lo que hay en la literatura. Otro de los parámetros, que deben calcularse para el caso mexicano es el R0, que permite calcular la tasa de transmisión o la tasa de contagio de una enfermedad.

De esta manera, estimaron la tasa de transmisión en México una vez que antes y después del inicio de la Jornada nacional de sana distancia, para verificar hasta qué punto se había logrado reducir la transmisión con esa medida de mitigación, y eso forma parte de sus resultados.

Otra cosa que observaron es que —según las estimaciones de su modelo— el pico del brote epidémico era más probable que se diera en la Ciudad de México alrededor del 1 de junio. Aunque tenían rangos de valores que les daban todo un abanico de predicciones y no era sólo una fecha.

“Nuestro estudio consideraba los dos escenarios: qué es lo que hubiera pasado si no había ningún tipo de restricción a la movilidad, y lo que ocurriría si sí la había”.

Si no había ningún tipo de restricción se preveía que el pico de la epidemia fuera alrededor del 4 de mayo, y si sí la había, se posponía a inicios de junio.

“Una posible estrategia a futuro sería aumentar la capacidad para procesar pruebas rápido, con la intención de contener brotes locales desde el inicio. Sin embargo, esto conlleva un esfuerzo logístico y un gasto económico considerables, por lo que debe contrastarse con otras estrategias. Otra cosa que es bueno enfatizar es el uso del tapabocas, porque hay suficiente evidencia que indica que si todo mundo lo usa, se reduce notablemente la tasa de transmisión, y eso es parte de los que se quiere lograr con las medidas de distanciamiento social, por lo que es un auxiliar muy importante”.

Por otro lado, el uso de tapabocas no debe verse como la panacea porque esto, afirma, puede generar una confianza excesiva en la población y hacer sentir que con usarlo ya no corre riesgo de contagiarse, aunado a que hay protocolos para su uso adecuado y efectivo, por lo que debe instruirse a la población sobre la importancia de usarlos de manera adecuada a fin de que tengan un impacto real.

“Hasta que no esté cerrado el capítulo va a ser muy difícil saber exactamente si todo ha sido adecuado o no. Yo no me quedo con una mala impresión del manejo que han tenido las autoridades, tomando en cuenta que estamos ante un sistema de salud con insuficiencias crónicas, con décadas de estar mal financiado, en el que se ha estado minando todo el sistema público de salud en favor del privado, entonces qué podemos esperar ahora. Creo que con lo que se tiene se ha hecho algo y la respuesta ha sido decorosa, pero hasta que no veamos realmente —a la distancia— todo bien transcurrido, no vamos a saber con exactitud”.

“Me parece que es muy adecuado considerar el enfoque bayesiano e intentar cuestionar todos los parámetros. Entre las cosas que vale la pena explorar podrían estar fijar un par de parámetros como, por ejemplo, cuál es la duración del periodo de latencia, cuál es el periodo de infecciosidad, y algo que le modificaría al modelo es incluir a los pacientes hospitalizados entre los que pueden ocasionar contagio, cosa que no estamos haciendo en esta primera versión del modelo y que es criticable pero puede modificarse”.

Los resultados del estudio indican que la ciudad requiere evaluar las estrategias de mitigación que a la fecha están siendo implementadas y en las que los modelos matemáticos pueden ser centrales para este esfuerzo, no obstante, se requieren ciertas condiciones para una aplicación eficiente.

De acuerdo con sus modelos, el pico está sucediendo justamente en el mes de junio, tras lo que se esperaría que comience a bajar la transmisión. Bajo las condiciones actuales, se esperaría para septiembre tener un número bajo de infectados nuevos por día. El modelo está enfocado a la primera ola y no pretende predecir más allá del 14 de septiembre, ni tampoco está tomando en cuenta posibles rebrotes.

Se trata de un modelo “bastante cauteloso” —afirma la investigadora— precisamente porque contempla muchas caracterizaciones diferentes, y simplemente dice vamos a tomarlas en cuenta todas para actuar considerando el escenario más difícil y entonces evitar que nos rebase la epidemia.

“Un poco lo que buscábamos era intentar alertar que no se terminara la Jornada Nacional de Sana Distancia antes de que llegáramos al pico. Hay una cosa que hay que tomar en cuenta: independientemente del modelo considerado, cuando las autoridades hablan del éxito en el control de la epidemia, la gente cambia su comportamiento y empieza a salir más, de forma que la predicción de los modelos se desvía de la situación actual, pues estaban ajustados para la situación pasada. Si la gente ahora se está moviendo más, está aumentando la tasa de transmisión, y deben recalcularse los parámetros”.